¿Es cuestión de recursos?: ‘Rankings’ universitarios y productividad

Los presupuestos explican parcialmente los resultados de los campus en las clasificaciones internacionales pero las políticas de recursos humanos son clave

En los últimos años hemos sido testigos del desarrollo de un nuevo sector productivo relacionado con la sociedad de la información: la industria de los rankings universitarios y de las instituciones de investigación. Empresas, Gobiernos, organismos internacionales así como investigadores producen rankings que permiten a los medios de comunicación llenar páginas y generar noticias con cierta regularidad.

Los rankings suponen la medición de una o diversas variables y un ordenamiento de los resultados (o clasificación de las unidades objeto de la medición); sin embargo, con frecuencia sus modos de elaboración son poco transparentes e incluso dejan mucho que desear metodológicamente; la lectura de la letra pequeña, si existe, no permitiría sacar muchas de las conclusiones que habitualmente se sacan.

Hay dos grandes tendencias en este negocio: a) La elaboración de rankings sintéticos (de países, regiones, universidades, etc.) que utilizan diversas variables con grados de medición empírica muy heterogéneos, que luego se integran y ponderan para obtener el resultado deseado; en este campo están el ranking de Shanghái (ARWU), Times Higher Education (THE), QS o de visibilidad en Internet (Webometrics Ranking). b) Otros, conscientes de la complejidad de agregar indicadores muy diversos en un valor número único (muy atractivo para los medios de comunicación) han optado, cuando hacen rankings a través de la comparación, por construir series de indicadores de posicionamiento, con identificación clara de la variable de referencia. La OCDE (http://www.oecd-ilibrary.org/science-and-technology/oecd-science-technology-and-industry-scoreboard-2013_sti_scoreboard-2013-en ) lidera esta visión de aportar múltiples indicadores, pero sin la manipulación artificial que supone su integración en un índice sintético; aquí están también, por ejemplo los rankings de producción científica (Leiden Ranking, Scimago Institutions Ranking).

Los rankings han venido para quedarse. A pesar de sus imperfecciones se han convertido en elementos de la información disponible sobre nuestras instituciones que no pueden ser ignorados por los responsables de las universidades, ni por los de las políticas universitarias y de investigación.

Las universidades son organizaciones complejas. Tienen varias misiones (y tipos de resultados): docencia (formación e inserción laboral), investigación (publicaciones y patentes) y transferencia de conocimientos (servicios y colaboraciones con la empresa y la sociedad), y los rankings existentes tienden a medirlas parcialmente o de forma incompleta, o por medio de los artefactos estadísticos que son los indicadores sintéticos.

Sin embargo, los rankings ofrecen aproximaciones al posicionamiento de unas universidades con relación a otras, información que los responsables de las mismas no pueden ignorar, porque esos indicadores retroalimentan el ciclo de la reputación y de la credibilidad. La comparación con otros, eso que se llama benchmarking, es una actividad básica de la información que los responsables del sistema deben manejar porque sitúa a cada universidad en su entorno y en su contexto y le permite aprender y tomar mejores decisiones.

Por ejemplo, el hecho tan destacado por la prensa de que apenas alguna universidad española estaría entre las 200 primeras del mundo (esas representan el 1% del total mundial) y poco mas de una docena entre las primeras quinientas, aunque suponga una puesta en cuestión del conjunto del sistema universitario o de investigación español, esconde una muy significativa especialización de las universidades en las diversas misiones. Al mismo tiempo, las universidades disponen de niveles diversos de recursos públicos y a la vez, demuestran una relación muy variada entre los recursos públicos que reciben y sus resultados (en cualquiera de las dimensiones: inserción de sus titulados en el mercado de trabajo, publicaciones científicas, patentes, servicio a la industria, etc.).

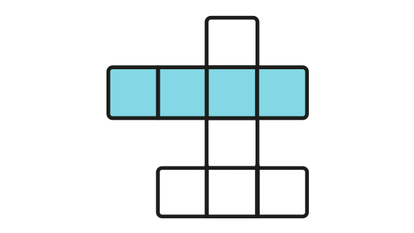

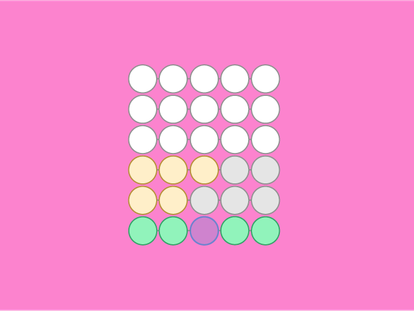

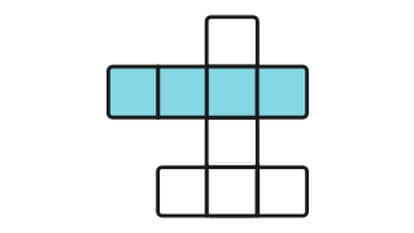

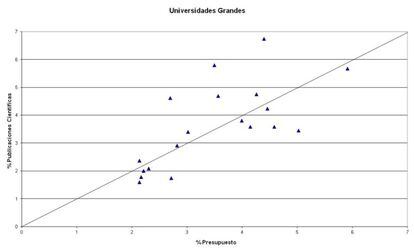

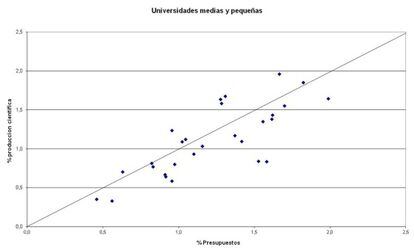

Es necesario diferenciar entre la posición de las universidades en cada una de las misiones y su rendimiento específico. Como ejemplo, una comparación simple entre los presupuestos que reciben y los resultados científicos que producen señala la heterogeneidad en la productividad de nuestras universidades. La comparación entre el valor acumulado de los últimos cinco años del presupuesto de cada universidad y su producción científica en revistas indexadas en Scopus, (normalizadas como proporciones del conjunto del sistema público) puede verse en los gráficos 1 y 2 adjuntos. Los gráficos presentan en el eje de la abscisa (X) los porcentajes del total de los presupuestos universitarios (euros) que cada universidad tiene y en el eje de ordenadas (Y) los porcentajes del total de la producción científica (número total de publicaciones) de cada universidad. Cada punto representa la posición de una universidad: los mejores resultados son para aquellas que están posicionadas por encima de la diagonal; a más distancia de la diagonal mejores resultados. Los peores resultados para las que están debajo de la diagonal.

Cuando uno examina las universidades públicas y compara sus presupuestos con sus resultados (por ejemplo, productividad científica) observa una correlación limitada. Comparando universidades dentro del mismo rango presupuestario, y controlando por la especialización científica, observamos diferencias significativas entre ellas. Por ejemplo, hay universidades cuya contribución al total nacional de publicaciones es superior a la proporción del presupuesto que reciben: en otras se da lo contrario. En el primer grupo, entre las de mayor tamaño están, por ejemplo, Barcelona, Autónoma de Barcelona, Politécnica de Cataluña, Autónoma de Madrid, Oviedo, Valencia o Zaragoza, y entre las más pequeñas están, por ejemplo, Pompeu Fabra, Rovira i Virgili, Vigo, Cantabria, Islas Baleares, etc.

Los recursos disponibles (o presupuestos) explican parcialmente los resultados agregados, pero hay que recordar un argumento común en la Sociología de las Organizaciones, relativo a que la variable que mejor explica, a medio plazo, los resultados de las organizaciones en general (y de las universidades en particular) es su política de recursos humanos (captación y retención del talento) y la flexibilidad con la que los responsables de las mismas pueden gestionarla.

Luis Sanz Menéndez y Laura Cruz son investigadores en el Instituto de Políticas y Bienes Públicos del CSIC.